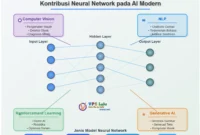

Sejarah Neural Network dari 1943 Hingga RNN, LSTM, GAN hingga LLM. Kecerdasan artifisial (AI) telah menjadi salah satu teknologi paling transformatif abad ke-21, mengubah cara kita berinteraksi dengan dunia digital dan memecahkan masalah kompleks. Di jantung revolusi ini terletak Jaringan Saraf Tiruan atau Neural Network, sebuah pendekatan komputasi yang terinspirasi oleh cara kerja otak manusia. Namun, seperti banyak terobosan ilmiah, perjalanan neural network bukanlah lintasan linier yang mulus. Sejarahnya diwarnai oleh momen-momen kejayaan, periode stagnasi, dan kebangkitan dramatis yang membentuk lanskap AI seperti yang kita kenal saat ini.

Artikel ini menelusuri perjalanan panjang dan berliku neural network, dimulai dari konseptualisasi awal pada tahun 1940-an hingga perkembangan model-model canggih yang mendominasi landscape AI kontemporer.

Warren McCulloch dan Walter Pitts

Konsep Neural Network (Jaringan Saraf Tiruan) pertama kali diperkenalkan oleh (McCulloch dan Pitts, 1943) yang merupakan salah satu karya pionir dalam bidang neurologi komputasional dan teori jaringan saraf tiruan. Dalam makalah ini, McCulloch dan Pitts memperkenalkan model neuron formal , yang merupakan representasi matematis dan logis dari cara kerja neuron biologis di otak manusia. Model ini menjadi dasar bagi pengembangan neural network modern.

Model yang mereka usulkan menggunakan konsep neuron biner (yang hanya dapat menghasilkan output 0 atau 1) dan menunjukkan bagaimana neuron-neuron tersebut dapat dihubungkan untuk membentuk jaringan yang mampu melakukan perhitungan logis mirip dengan otak manusia. Meskipun model ini sangat sederhana dibandingkan dengan teknologi neural network saat ini, artikel ini meletakkan fondasi teoretis untuk pengembangan AI modern.

Signifikansi Artikel

Artikel ini sering dikutip sebagai tonggak awal dalam sejarah neural network karena beberapa alasan:

- Pendekatan Matematis Pertama : McCulloch dan Pitts adalah yang pertama kali mencoba menjelaskan fungsi neuron secara matematis, yang kemudian menjadi dasar untuk penelitian lebih lanjut tentang neural network.

- Inspirasi untuk Penelitian Berikutnya : Artikel ini menginspirasi generasi peneliti seperti Frank Rosenblatt (penemu Perceptron pada 1958) dan Geoffrey Hinton (pelopor deep learning), yang mengembangkan konsep ini menjadi teknologi praktis.

- Interdisipliner : Artikel ini menggabungkan ide-ide dari neurologi, matematika, dan logika, yang membuatnya relevan di berbagai bidang studi.

Frank Rosenblatt

Namun, momen penting dalam sejarah neural network terjadi pada (Rosenblatt, 1958) yang memperkenalkan Perceptron, sebuah model komputasi yang dirancang untuk meniru cara otak manusia mengenali pola. Perceptron adalah salah satu jaringan saraf tiruan pertama yang dapat “belajar” dari data melalui proses pelatihan, yang kemudian menjadi dasar untuk pengembangan algoritma pembelajaran mesin (machine learning).

Rosenblatt menjelaskan bagaimana Perceptron bekerja menggunakan lapisan tunggal neuron (single-layer neural network) yang dapat diklasifikasikan sebagai linear classifier. Model ini mampu memisahkan data menjadi dua kelas berdasarkan garis pemisah linear (linear boundary). Meskipun memiliki keterbatasan, Perceptron menjadi langkah besar menuju pengembangan neural network yang lebih kompleks.

Signifikansi Perceptron

Artikel Rosenblatt ini sangat penting dalam sejarah neural network karena beberapa alasan:

- Pengenalan Konsep Pembelajaran : Perceptron adalah model pertama yang secara eksplisit menunjukkan bagaimana sebuah sistem dapat “belajar” dari data melalui penyesuaian bobot (weights ) berdasarkan kesalahan (error ).

- Dasar untuk Neural Network Modern : Meskipun Perceptron hanya mampu menangani masalah linear, ide ini kemudian dikembangkan menjadi Multi-Layer Perceptron (MLP) dan deep learning .

- Aplikasi Praktis : Rosenblatt mendemonstrasikan Perceptron pada perangkat keras yang disebut Mark I Perceptron, yang digunakan untuk tugas-tugas seperti pengenalan karakter tulisan tangan.

Marvin Minsky dan Seymour Papert

Meskipun Perceptron Rosenblatt membuka jalan bagi neural network, perkembangan bidang ini mengalami hambatan signifikan setelah publikasi buku “Perceptrons” oleh (Minsky dan Papert, 1969). Dalam buku ini, mereka menganalisis secara matematis dan menunjukkan keterbatasan fundamental dari Perceptron lapisan tunggal.

Minsky dan Papert membuktikan bahwa Perceptron tidak mampu memecahkan masalah yang tidak dapat dipisahkan secara linear (non-linearly separable), dengan contoh paling terkenal adalah masalah XOR. Dalam masalah XOR, input (0,0) dan (1,1) menghasilkan output 0, sementara input (0,1) dan (1,0) menghasilkan output 1, yang tidak dapat direpresentasikan oleh garis pemisah tunggal.

Signifikansi Buku Publikasi ini memiliki dampak besar pada perkembangan neural network:

- AI Winter: Kritik keras ini berkontribusi pada periode yang dikenal sebagai “AI Winter” di mana pendanaan dan minat terhadap penelitian neural network menurun drastis selama tahun 1970-an.

- Pengarahan Ulang Penelitian: Banyak peneliti beralih ke pendekatan lain dalam AI seperti sistem berbasis aturan (rule-based systems).

- Fondasi untuk Solusi Masa Depan: Ironisnya, identifikasi keterbatasan ini juga membantu peneliti memahami kebutuhan akan arsitektur yang lebih kompleks, yang kemudian mengarah pada pengembangan jaringan multi-layer.

Paul Werbos dan Backpropagation

Meskipun mengalami masa surut, penelitian neural network tidak sepenuhnya terhenti. Terobosan besar terjadi ketika (Werbos, 1974) mengembangkan algoritma Backpropagation dalam disertasi doktoralnya, meskipun konsep ini baru mendapat perhatian luas pada tahun 1980-an.

Backpropagation adalah metode pembelajaran yang efisien untuk jaringan multi-layer, memungkinkan penyesuaian bobot pada semua lapisan berdasarkan kesalahan output. Algoritma ini bekerja dengan propagasi balik (menyebarkan kembali) kesalahan dari output ke lapisan-lapisan sebelumnya, memungkinkan neural network untuk mempelajari representasi internal yang kompleks.

Signifikansi Backpropagation

- Mengatasi Keterbatasan Perceptron: Backpropagation memungkinkan pelatihan jaringan multi-layer yang dapat memecahkan masalah non-linear seperti XOR.

- Efisiensi Komputasi: Dibandingkan metode lain, backpropagation menawarkan cara yang lebih efisien untuk melatih jaringan yang kompleks.

- Universalitas: Terbukti bahwa neural network multi-layer dengan backpropagation adalah universal approximator, artinya dapat mendekati hampir semua fungsi kontinu dengan ketelitian arbitrer.

Kebangkitan Neural Network: Tahun 1980-an

Setelah periode stagnan, neural network mengalami kebangkitan pada awal 1980-an dengan kontribusi dari beberapa peneliti utama:

John Hopfield

(Hopfield, 1982) memperkenalkan Hopfield Network, jenis neural network rekuren yang dirancang khusus untuk memori asosiatif. Network ini mampu menyimpan dan mengambil kembali pola-pola dari memori, mirip dengan cara kerja memori manusia.

Hopfield juga menghubungkan neural network dengan konsep fisika statistik seperti fungsi energi, yang memberikan dasar teoretis yang kuat bagi bidang ini.

Geoffrey Hinton dan Terrence Sejnowski

(Hinton dan Sejnowski, 1983) mengembangkan Boltzmann Machine, sebuah jenis stokastik neural network yang dapat belajar dari data tanpa pengawasan (unsupervised learning). Mereka menggunakan prinsip-prinsip termodinamika untuk melatih network ini.

Penelitian mereka juga meletakkan dasar untuk Deep Belief Networks yang dikembangkan kemudian, yang menjadi prekursor penting bagi deep learning modern.

Convolutional Neural Networks (CNN)

Perkembangan penting lainnya adalah munculnya Convolutional Neural Networks oleh (LeCun dkk., 1989). Yann LeCun dan koleganya mengembangkan arsitektur ini berdasarkan studi tentang sistem visual biologis, dengan menerapkan operasi konvolusi untuk mengekstrak fitur lokal dari data.

LeCun mengimplementasikan CNN yang disebut LeNet-5 untuk pengenalan digit tulisan tangan, yang kemudian digunakan oleh U.S. Postal Service untuk membaca kode pos secara otomatis. Model ini mencakup lapisan konvolusi, pooling, dan fully-connected, yang menjadi pola dasar bagi arsitektur CNN modern.

Signifikansi CNN

- Invariansi Translasi: CNN memiliki kemampuan built-in untuk mengenali pola terlepas dari posisinya dalam gambar.

- Parameter Sharing: Dengan berbagi parameter dalam operasi konvolusi, CNN memiliki jauh lebih sedikit parameter dibandingkan jaringan fully-connected, membuatnya lebih efisien.

- Hierarki Representasi: CNN secara alami belajar representasi hierarkis, dari fitur sederhana seperti tepi pada lapisan awal hingga fitur kompleks pada lapisan dalam.

AI Winter Kedua dan Kemunculan Alternatif

Meskipun ada kemajuan, neural network menghadapi periode tantangan kedua pada tahun 1990-an dan awal 2000-an. Sementara beberapa peneliti tetap fokus pada neural network, banyak yang beralih ke metode alternatif seperti Support Vector Machines (SVM) dan Random Forests yang sering kali memberikan hasil lebih baik dengan komputasi yang lebih sedikit.

Keterbatasan utama neural network pada periode ini adalah:

- Kebutuhan Data Besar: Neural network memerlukan jumlah data yang sangat besar untuk pelatihan efektif.

- Kebutuhan Komputasi: Pelatihan network yang dalam membutuhkan daya komputasi yang tidak tersedia secara luas.

- Vanishing Gradient Problem: Masalah gradient yang menghilang membuat pelatihan jaringan dalam sangat sulit.

Revolusi Deep Learning: 2006 dan Seterusnya

Kebangkitan besar neural network dimulai sekitar tahun 2006 ketika beberapa faktor penting bertemu:

Pre-training dan Deep Belief Networks

(Hinton dkk., 2006) memperkenalkan metode greedy layer-wise pre-training untuk Deep Belief Networks, mengatasi masalah vanishing gradient. Pendekatan ini memungkinkan pelatihan jaringan yang jauh lebih dalam daripada sebelumnya.

Kemajuan Hardware: GPU

Penggunaan Graphics Processing Units (GPU) untuk pelatihan neural network, yang dipopulerkan oleh (Raina dkk., 2009), memberikan peningkatan kecepatan komputasi yang dramatis. GPU mampu melakukan operasi paralel dalam jumlah besar yang sangat cocok untuk perhitungan matriks dalam neural network.

Dataset Besar

Munculnya dataset besar seperti ImageNet (dengan lebih dari satu juta gambar) menyediakan data yang cukup untuk melatih network yang kompleks.

AlexNet dan Revolusi Computer Vision

Titik balik penting terjadi pada tahun 2012 ketika (Krizhevsky dkk., 2012) memenangkan kompetisi ImageNet dengan AlexNet, sebuah CNN dalam yang mencapai akurasi jauh lebih tinggi daripada metode sebelumnya. AlexNet menggunakan beberapa inovasi penting:

- ReLU Activation: Fungsi aktivasi Rectified Linear Unit yang mengatasi masalah vanishing gradient.

- Dropout: Teknik regularisasi yang mencegah overfitting.

- Data Augmentation: Teknik untuk secara artifisial meningkatkan ukuran dataset pelatihan.

Keberhasilan AlexNet memicu ledakan minat dalam deep learning, dengan arsitektur yang semakin dalam dan kompleks seperti VGGNet, GoogLeNet (Inception), dan ResNet.

Recurrent Neural Networks (RNN) dan LSTM

Untuk data sekuensial seperti teks dan suara, Recurrent Neural Networks menjadi arsitektur pilihan. Namun, RNN tradisional menderita masalah vanishing gradient ketika menangani sekuens panjang. (Hochreiter dan Schmidhuber, 1997) mengatasi masalah ini dengan memperkenalkan Long Short-Term Memory (LSTM) networks.

LSTM menggunakan mekanisme gerbang (gate mechanisms) untuk mengontrol arus informasi, memungkinkan jaringan untuk “mengingat” informasi untuk jangka waktu yang panjang. Varian LSTM seperti Gated Recurrent Units (GRU) juga dikembangkan untuk efisiensi komputasi yang lebih baik.

Generative Models dan GANs

Perkembangan besar lainnya adalah munculnya model generatif yang kuat. (Goodfellow dkk., 2014) memperkenalkan Generative Adversarial Networks (GANs), yang terdiri dari dua jaringan yang bersaing—generator dan discriminator—dalam proses pelatihan zero-sum game.

GANs mampu menghasilkan gambar realistis dan telah diterapkan untuk berbagai tugas seperti:

- Pembuatan gambar fotorealistik

- Super-resolusi

- Image-to-image translation

- Augmentasi data

Attention Mechanism dan Transformers

Salah satu terobosan terbesar dalam beberapa tahun terakhir adalah pengembangan attention mechanism, yang memungkinkan model untuk fokus pada bagian-bagian tertentu dari input saat menghasilkan output. (Vaswani dkk., 2017) merevolusi NLP (Natural Language Processing) atau pemrosesan bahasa alami dengan arsitektur Transformer yang sepenuhnya berbasis mekanisme attention.

Transformers memiliki beberapa keunggulan dibanding RNN/LSTM:

- Paralelisasi: Dapat memproses seluruh sekuens secara paralel, bukan sekuensial.

- Koneksi Jarak Jauh: Dapat menangkap dependensi jarak jauh lebih efektif.

- Scaling: Dapat diskalakan ke ukuran model yang sangat besar.

Model Transformer telah mendorong kemajuan luar biasa dalam NLP, dengan model terkenal seperti BERT, GPT, T5, dan banyak lainnya.

Neural Network Modern: Era Foundation Models

Saat ini, neural network telah berkembang menjadi apa yang disebut Foundation Models—model besar yang dilatih pada data dalam jumlah sangat besar dan dapat disesuaikan untuk berbagai tugas. Contoh utamanya:

- Large Language Models (LLMs): Seperti GPT-4, PaLM, dan Claude, yang mencapai kemampuan bahasa manusia yang mengesankan.

- Diffusion Models: Seperti DALL-E, Stable Diffusion, dan Midjourney untuk pembuatan gambar.

- Multimodal Models: Yang dapat bekerja dengan beberapa jenis input seperti teks dan gambar secara bersamaan.

Arah Perkembangan Terkini

Neural network terus berevolusi dengan beberapa tren terbaru:

- Scaling Laws: Penelitian menunjukkan bahwa kinerja model sering meningkat dengan pola yang dapat diprediksi saat ukuran model, data, dan komputasi ditingkatkan.

- Efficient Architectures: Fokus pada pengembangan arsitektur yang lebih efisien komputasi seperti MobileNet dan EfficientNet.

- Neural Architecture Search (NAS): Menggunakan AI untuk merancang arsitektur neural network optimal.

- Self-Supervised Learning: Mengurangi ketergantungan pada data berlabel dengan memanfaatkan data tak berlabel dalam jumlah besar.

- Neuro-symbolic AI: Menggabungkan kekuatan neural network dengan sistem berbasis simbol untuk meningkatkan penalaran.

Dari konsep sederhana McCulloch dan Pitts hingga model canggih saat ini, neural network telah mengalami evolusi luar biasa. Kemajuan dalam hardware, algoritma, dan ketersediaan data telah memungkinkan aplikasi yang dulunya tidak terbayangkan, dari pemrosesan bahasa alami hingga diagnosis medis. Meskipun menghadapi periode tantangan, bidang ini terus maju dan membentuk dasar bagi sebagian besar sistem AI modern.R

Daftar Pustaka

- Goodfellow, I. J., Pouget-Abadie, J., Mirza, M., Xu, B., Warde-Farley, D., Ozair, S., Courville, A., & Bengio, Y. (2014). Generative adversarial nets. Advances in Neural Information Processing Systems, 27, 2672-2680.

- Hinton, G. E., Osindero, S., & Teh, Y. W. (2006). A fast learning algorithm for deep belief nets. Neural Computation, 18(7), 1527-1554. https://doi.org/10.1162/neco.2006.18.7.1527

- Hinton, G. E., & Sejnowski, T. J. (1983). Optimal perceptual inference. In Proceedings of the IEEE conference on Computer Vision and Pattern Recognition (Vol. 448, pp. 448-453).

- Hopfield, J. J. (1982). Neural networks and physical systems with emergent collective computational abilities. Proceedings of the National Academy of Sciences, 79(8), 2554-2558. https://doi.org/10.1073/pnas.79.8.2554

- Hochreiter, S., & Schmidhuber, J. (1997). Long short-term memory. Neural Computation, 9(8), 1735-1780. https://doi.org/10.1162/neco.1997.9.8.1735

- Krizhevsky, A., Sutskever, I., & Hinton, G. E. (2012). ImageNet classification with deep convolutional neural networks. Commun. ACM 60, 6 (June 2017), 84–90. https://doi.org/10.1145/3065386

- LeCun, Y., Boser, B., Denker, J. S., Henderson, D., Howard, R. E., Hubbard, W., & Jackel, L. D. (1989). Backpropagation applied to handwritten zip code recognition. Neural computation, 1(4), 541-551. https://doi.org/10.1162/neco.1989.1.4.541

- McCulloch, W. S., & Pitts, W. (1943). A logical calculus of the ideas immanent in nervous activity. The Bulletin of Mathematical Biophysics, 5(4), 115-133. https://doi.org/10.1007/BF02478259

- Minsky, M., & Papert, S. (1969). Perceptrons: An introduction to computational geometry. MIT Press.

- Rosenblatt, F. (1958). The perceptron: A probabilistic model for information storage and organization in the brain. Psychological Review, 65(6), 386–408. https://doi.org/10.1037/h0042519

- Werbos, P. J. (1974). Beyond regression: New tools for prediction and analysis in the behavioral sciences. Harvard University, PhD Dissertation.

- Raina, R., Madhavan, A., & Ng, A. Y (2009). Large-scale deep unsupervised learning using graphics processors. In Proceedings of the 26th Annual International Conference on Machine Learning (ICML ’09). Association for Computing Machinery, New York, NY, USA, 873–880. https://doi.org/10.1145/1553374.1553486

- Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A. N., Kaiser, Ł., & Polosukhin, I. (2017). Attention is all you need. Advances in Neural Information Processing Systems, 30, 5998-6008. https://doi.org/10.48550/arXiv.1706.03762