Flash Attention sebagai Solusi Kelemahan Self-Attention. Dalam era perkembangan Large Language Models (LLMs) yang pesat, efisiensi komputasi menjadi tantangan utama yang harus diatasi. Salah satu inovasi paling signifikan dalam mengatasi masalah ini adalah Flash Attention, sebuah teknik revolusioner yang mengubah cara komputasi self-attention dilakukan pada arsitektur Transformer.

Memahami Tantangan Self-Attention Tradisional

Kompleksitas Kuadratik: Hambatan Utama

Self-attention merupakan jantung dari arsitektur Transformer yang memungkinkan model memahami hubungan antar token dalam sebuah sequence. Namun, implementasi tradisional memiliki kelemahan mendasar berupa kompleksitas komputasi kuadratik O(N²) terhadap panjang input.

Kompleksitas ini terjadi karena setiap elemen dalam vektor query (Q) harus dihitung dengan setiap elemen dalam vektor key (K). Proses ini menghasilkan matriks QK^T berukuran N×N yang harus disimpan dalam memori sebelum dilakukan operasi softmax untuk mendapatkan attention score.

Implikasi Praktis

Ketika memproses dokumen panjang atau context window yang besar, kompleksitas O(N²) ini menjadi bottleneck yang signifikan. Sebagai contoh, untuk sequence dengan 10,000 token, diperlukan komputasi 100 juta operasi, sedangkan untuk 20,000 token, angka ini melonjak menjadi 400 juta operasi.

Masalah ini tidak hanya berdampak pada kecepatan komputasi, tetapi juga konsumsi memori yang eksponensial. High-bandwidth memory (HBM) pada GPU menjadi cepat penuh, membatasi kemampuan model untuk memproses input yang panjang.

Flash Attention: Pendekatan Inovatif

Prinsip Dasar Flash Attention

Flash Attention mengadopsi pendekatan yang fundamentally berbeda dalam menghitung self-attention. Alih-alih membangun dan menyimpan seluruh matriks attention N×N, teknik ini memecah matriks Query (Q), Key (K), dan Value (V) menjadi sub-matriks kecil yang dapat diproses secara efisien.

Mekanisme Kerja

Keunggulan utama Flash Attention terletak pada penggunaan fast SRAM (on-chip memory) untuk perhitungan batch-wise attention score. Proses ini melibatkan:

- Chunking: Matriks Q, K, dan V dipecah menjadi blok-blok kecil

- On-chip Computation: Perhitungan attention dilakukan langsung di SRAM yang lebih cepat

- Online Normalization: Partial softmax dihitung menggunakan teknik normalisasi online

- Memory Optimization: Tidak ada penyimpanan eksplisit matriks attention N×N

Kompleksitas Linear

Dengan pendekatan ini, Flash Attention berhasil mencapai kompleksitas linear O(N) terhadap panjang input, sebuah peningkatan dramatis dari O(N²) pada implementasi tradisional. Ini berarti waktu komputasi bertambah secara proporsional dengan panjang input, bukan secara kuadratik.

Penjelasan Flash Attention dalam Gambar

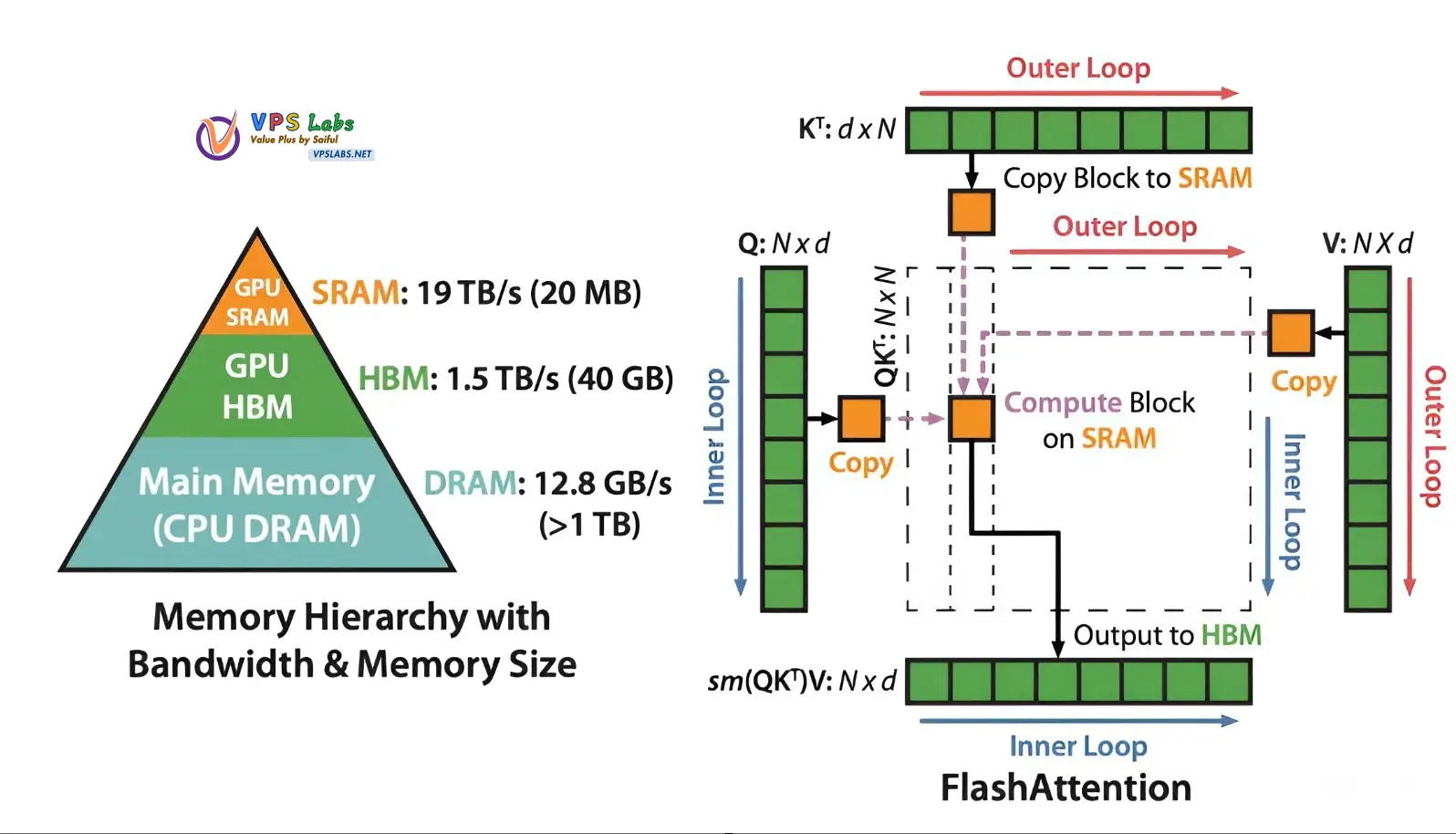

Gambar ini menjelaskan arsitektur dan mekanisme kerja Flash Attention dalam konteks hierarki memori GPU. Mari saya breakdown penjelasannya:

Hierarki Memori (Bagian Kiri)

Piramida memori menunjukkan trade-off antara kecepatan dan kapasitas:

- GPU SRAM: Paling cepat (19 TB/s) tapi kapasitas kecil (20 MB)

- GPU HBM: Sedang (1.5 TB/s) dengan kapasitas menengah (40 GB)

- CPU DRAM: Paling lambat (12.8 GB/s) tapi kapasitas besar (>1 TB)

Mekanisme Flash Attention (Bagian Kanan)

Proses Kerja:

- Outer Loop: Memproses matriks K^T (Key transpose) dan V (Value) dalam blok-blok

- Copy to SRAM: Blok dari K^T disalin ke SRAM yang cepat

- Inner Loop: Memproses matriks Q (Query) dalam blok-blok kecil

- Compute Block on SRAM: Perhitungan attention dilakukan di SRAM (bukan HBM)

- Output to HBM: Hasil akhir sm(QK^T)V disimpan ke HBM

Keunggulan Strategi Ini:

Memory Efficiency:

- Tidak menyimpan seluruh matriks attention N×N di memori

- Hanya memproses blok-blok kecil di SRAM yang cepat

Speed Optimization:

- Memanfaatkan bandwidth tinggi SRAM (19 TB/s vs 1.5 TB/s HBM)

- Mengurangi transfer data antara HBM dan unit komputasi

Scalability:

- Memungkinkan pemrosesan sequence yang sangat panjang

- Kompleksitas berubah dari O(N²) menjadi O(N)

Analogi Sederhana:

Bayangkan Anda harus mengalikan dua matriks raksasa. Alih-alih memuat seluruh matriks ke memori (yang akan memenuhi ruang), Flash Attention memotong matriks menjadi puzzle kecil, menghitung setiap potongan di “meja kerja cepat” (SRAM), lalu menyusun hasilnya.

Inilah yang membuat Flash Attention revolusioner – same accuracy, much better efficiency!

Keuntungan Signifikan Flash Attention

Peningkatan Kapasitas Pemrosesan

Flash Attention memungkinkan Transformer memproses sequence token hingga 8 kali lebih panjang dibandingkan standard self-attention. Ini membuka peluang untuk:

- Pemrosesan dokumen yang sangat panjang

- Context window yang lebih besar untuk tugas kompleks

- Kemampuan reasoning jangka panjang yang lebih baik

Efisiensi Pelatihan

Proses training model menjadi significantly lebih cepat dengan Flash Attention. Pengurangan memory footprint GPU yang drastis memungkinkan:

- Batch size yang lebih besar selama training

- Waktu pelatihan yang lebih singkat

- Efisiensi energi yang lebih baik

Akurasi Terjaga

Aspek paling penting dari Flash Attention adalah kemampuannya menghasilkan attention score yang exact sama dengan standard self-attention. Ini berarti tidak ada trade-off dalam hal akurasi model, hanya pure efficiency gain.

Dampak pada Industri AI

Demokratisasi LLMs

Flash Attention berperan penting dalam demokratisasi akses terhadap large language models. Dengan efisiensi komputasi yang lebih baik, organisasi dengan resource terbatas dapat:

- Melatih model yang lebih besar dengan hardware yang sama

- Menjalankan inference dengan biaya yang lebih rendah

- Mengembangkan aplikasi AI yang lebih accessible

Inovasi Aplikasi

Efisiensi Flash Attention membuka kemungkinan aplikasi baru yang sebelumnya tidak feasible, seperti:

- Real-time document analysis

- Long-form content generation

- Multi-modal processing dengan context panjang

Implementasi dalam Model Modern

Saat ini, sebagian besar LLMs modern telah mengadopsi Flash Attention solusi ini sebagai standard. Model-model populer seperti GPT-4, Claude, dan berbagai open-source alternatives memanfaatkan teknik ini untuk memberikan performa optimal.

Kesimpulan

Flash Attention merupakan breakthrough yang mengubah landscape komputasi dalam deep learning, khususnya untuk Transformer-based models. Dengan mengatasi bottleneck kompleksitas kuadratik dari standard self-attention, inovasi ini tidak hanya meningkatkan efisiensi komputasi tetapi juga membuka peluang baru dalam pengembangan AI yang lebih powerful dan accessible.

Adopsi Flash Attention solusi self attention dalam industri AI menandai langkah penting menuju era dimana large language models dapat digunakan secara lebih luas dan efisien, membawa manfaat teknologi AI kepada lebih banyak pengguna dan use case.